지난 몇 년간 OpenAI는 뛰어난 성능의 GPT 모델들을 내놓았지만, 연구자와 개발자 입장에서 가장 아쉬웠던 부분은 폐쇄적인 정책이었습니다. GPT‑4 계열 모델의 정확도와 정렬 능력은 놀라웠지만, 우리는 그것이 어떻게 동작하는지, 어떤 아키텍처 설계를 택했는지, 그리고 파인튜닝이 가능한지 알 방법이 없었습니다.

그러나 2025년 8월, 그 흐름이 바뀌기 시작했습니다. OpenAI는 gpt-oss-120b와 gpt-oss-20b 두 개의 모델을 Apache 2.0 라이선스로 공개했습니다. 이는 단순한 오픈 모델 그 이상이며, 실질적인 LLM 생태계 전환점이라고 판단합니다.

1. 모델 구조와 학습 전략: Mixture-of-Experts의 실전 적용

아키텍처 요약

| 모델 이름 |

총 파라미터 | 활성 파라미터 | Expert 수 | 레이어 수 |

| gpt-oss-20b | 21B | 3.6B | 32개 중 4개 | 24 |

| gpt-oss-120b | 117B | 5.1B | 128개 중 4개 | 36 |

OpenAI는 이 모델에서 Mixture-of-Experts(MoE) 구조를 채택했습니다. 이전까지 MoE는 Google의 GShard, DeepMind의 GLaM 등에서 실험적으로만 활용되었는데, 이제는 누구나 최신 대규모 MoE 모델을 로컬에서 실행하거나 커스터마이즈 할할 수 있게 된 것입니다.

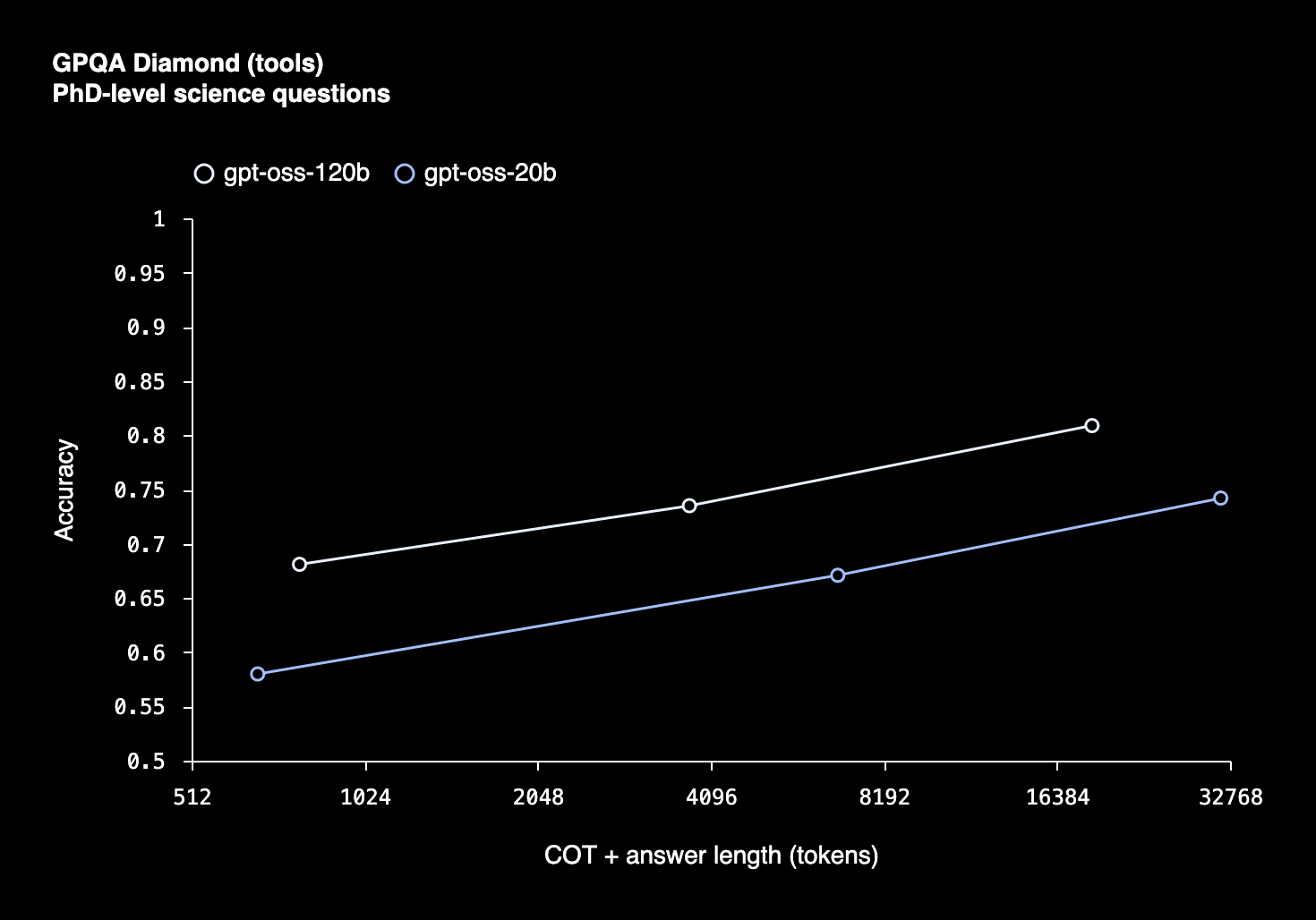

추론 시에는 오직 4개의 전문가만 활성화되므로, 실질적인 활성 파라미터 수는 3~5B 수준으로 줄어들고, 이는 메모리 효율과 성능을 동시에 확보하는 구조입니다. 아키텍처 상에서도 Grouped Multi-Query Attention, RoPE Positional Encoding, FlashAttention, 128k context 등의 최신 기법이 적용되었습니다.

2. 학습 데이터 및 정렬 방식

이 모델은 대부분 영문 데이터로 학습되었으며, 특히 STEM, 코딩, 고등 reasoning 중심의 도메인에서 성능이 높습니다.

포스트트레이닝은 GPT-4 계열에서 사용되던 SFT + PPO (Reinforcement Learning with Human Feedback) 방식과 유사한 절차를 따랐으며, 다음 기능이 포함됩니다:

- Chain-of-Thought reasoning 강화

- Function/tool calling 대응

- 보조 시스템 간 협업을 위한 agent alignment 구조

또한, OpenAI는 내부적으로 위험 평가 테스트(특히 생물학/사이버 보안 분야)도 병행하였고, 현재 수준의 모델이 고위험 임계값을 넘지 않았다고 판단했습니다(Model Safety 보고서).

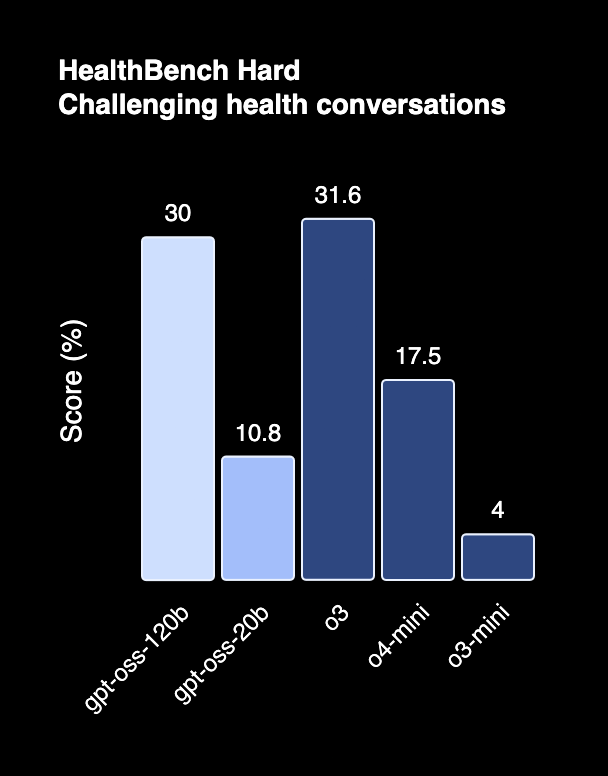

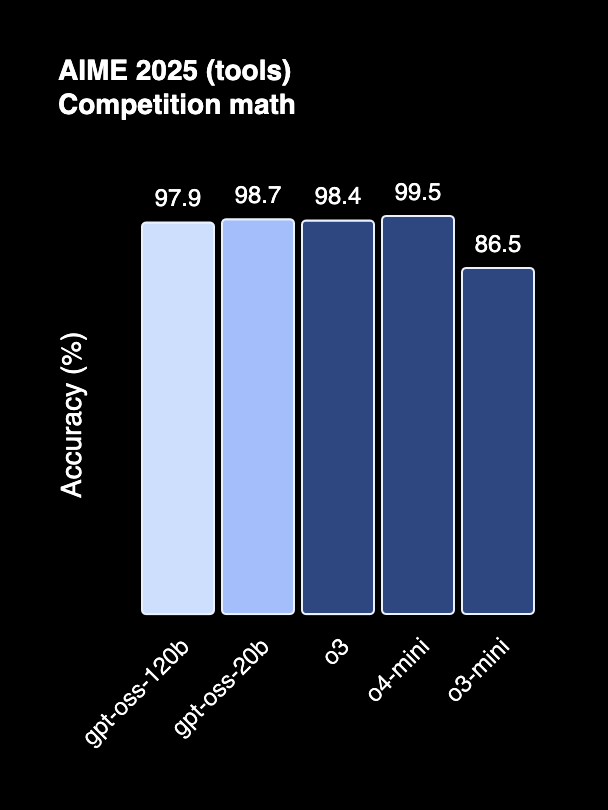

3. 성능 벤치마크: o4-mini와 대등한 수준

실제 성능은 어떨까요? OpenAI는 gpt-oss-120b가 o4-mini(OpenAI API에서 제공하는 GPT-4 압축형)와 유사한 성능을 보인다고 주장합니다.

대표적인 벤치마크 결과:

| Task |

o3-mini | gpt-oss-20b | o4-mini | gpt-oss-120b |

| GPQA Diamond | 77.0% | 71.5% | 81.4% | 80.1% |

| MMLU | - | 66.1% | - | 71.3% |

| HumanEval (코딩) | - | 37.1% | - | 42.0% |

특히 120B 모델은 고차원 추론과 코드 생성에서 강한 퍼포먼스를 보여주며, 20B도 상당히 균형 잡힌 성능을 보입니다.

|

|

|

|

|

|

4. 실무 환경에서의 사용성

이 모델들이 단지 연구 목적에만 국한되는 것은 아닙니다. OpenAI는 로컬 실행 및 클라우드 통합에 최적화된 구조를 염두에 두고 모델을 설계했습니다.

- gpt-oss-20b는 16 GB GPU에서도 추론 가능 (ex: RTX 3090, MacBook Pro M2 Max)

- gpt-oss-120b는 H100 80 GB 단일 GPU로 실행 가능

- 지원 플랫폼: Hugging Face Transformers / vLLM / Ollama / AWS Bedrock / Azure AI Foundry 등

또한 모델 카드에는 ONNX 및 TensorRT 변환 경로까지 안내되어 있어, 실질적인 제품 배포도 무리 없습니다.

5. 활용 방향: 연구, 제품, 로컬 에이전트까지

이 모델들은 단순히 LLM을 체험하는 데 그치지 않습니다. 아래와 같은 방향으로 실질적인 활용이 가능하리라 보입니다.

- 커스터마이즈 가능한 오픈 LLM 백본: 자사 도메인 지식으로 SFT를 진행해도 되고, LoRA 등으로 Efficient Fine-Tuning을 적용할 수도 있습니다. 특히 20B 모델은 온디바이스 LLM 파운데이션으로 매우 적합합니다.

- 개인/로컬 에이전트의 기반: 120B는 플러그인 기반 CoT 에이전트로, 20B는 로컬 명령어 기반 보조 AI로 이상적입니다.

- Prompt Engineering 연구 기반: 128k 컨텍스트를 실험할 수 있는 구조는 아직 희소하며, 이 모델은 다양한 long-context prompting 기법 (retrieval + summary + reflection)의 실험 플랫폼이 될 수 있습니다.

6. 마무리: 폐쇄에서 개방으로

GPT-OSS 시리즈는 OpenAI가 다시금 공공 기술 생태계로 발을 돌렸다는 실질적 신호입니다. Meta의 LLaMA 계열, Mistral, DeepSeek에 이어 이제 OpenAI까지 공개 모델을 내놓은 상황에서, 앞으로 우리는 더 많은 “합리적” LLM 설계와, 그 위에서의 실제 사용자 중심 경험 최적화로 이동할 수 있게 되었습니다.

연구와 제품 개발 사이, 가장 실용적인 시점에 있는 모델들입니다. 지금 실험해 보기에 이보다 더 적절한 시점은 없을 것입니다.

📌 관련 링크

- 공식 소개: https://openai.com/index/introducing-gpt-oss

- 모델 세이프티 논문: PDF 논문

- Hugging Face: https://huggingface.co/openai

댓글