MacBook에서도 비교적 간단한 설정만으로, 20B 규모의 언어 모델을 띄워 직접 활용할 수 있습니다.

실험 환경

저는 23년형 Macbook pro (CPU는 M3 pro, 메모리는 36기가) 에서 실험했습니다.

GUI로 실행하는 방법

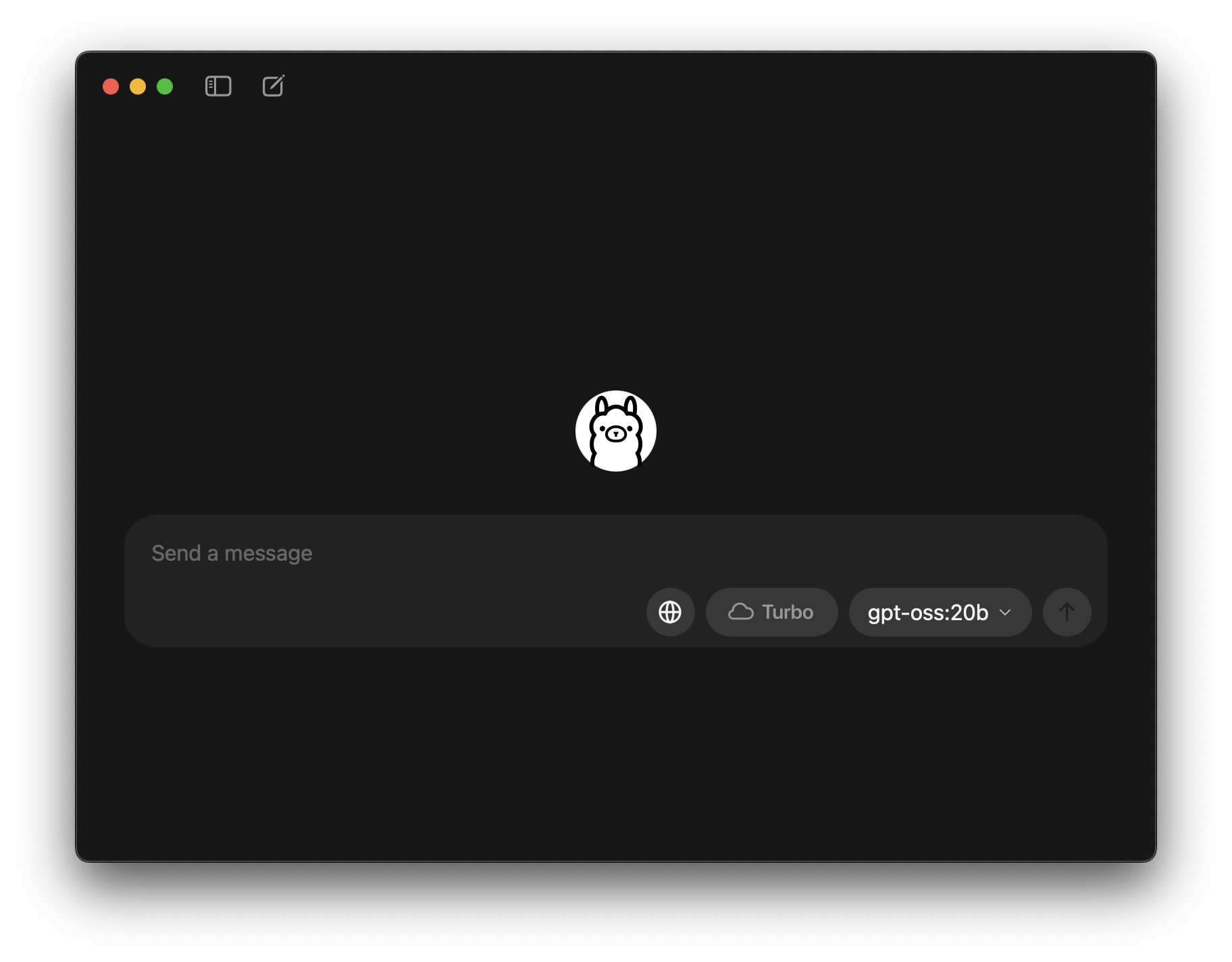

가장 쉬운 방법은 Ollama를 이용하는 방법입니다. 다운로드 페이지에서 다운받아 실행하면, 다양한 모델들을 실험해볼 수 있는 ChatGPT와 유사한 챗 인터페이스를 보실 수 있습니다.

챗 화면의 오른쪽 아래에 모델을 드롭다운 메뉴로 선택할 수 있고, 처음 시작시에 모델 바이너리 다운받는 시간이 걸립니다. 다른 모델은 로컬에서 돌릴 생각을 못해봤고, gpt-oss:20b 모델만 테스트 해봤습니다. 유료 섭스크립션 플랜인 turbo를 활용하면 Ollama가 클라우드에서 서비스하는 큰 모델들을 테스트해볼 수 있습니다.

CUI로 실행하는 방법

위의 GUI 실행 방식에서 언급된 Ollama 다운로드 페이지에서 다운 및 설치를 진행하면, ollama executable을 활용할 수 있습니다.

추가로, 아래의 커맨드로 직접 CUI 툴 설치가 가능합니다.

# 패키지 매니저인 HomeBrew가 설치되어 있으면,

brew install ollama

# HomeBrew가 설치되어 있지 않으면,

curl https://ollama.ai/install.sh | shOllama 툴이 설치된 이후에는 아래 명령어를 통해서 실행할 수 있습니다.

# 여러 질문을 챗 인터페이스 형태로 진행하려면,

ollama run gpt-oss:20b

# 한 질문에 대해서만 실행한다면,

ollama run gpt-oss:20b "{질문}"

감상평

기존의 stochastic decoding 특성상 같은 질문을 여러번 던졌을 때 매번 다른 답변이 나오네요. 어떻게 고정할 수 있을지 (temperature?) 는 아직 확인하지 못했어요.

랩탑에서 실제 인퍼런스가 실행되다보니 속도는 좀 느린 편이긴 하나, LLM을 로컬에서 사용할 수 있다는 것이 꽤 매력적이네요. 이를 활용한 on-device/edge AI가 어떤 방향으로 발전할지 매우 궁금하네요.

댓글