Title

Banishing LLM Hallucinations Requires Rethinking Generalization

Links

Summary

이 연구는 LLM의 일반적인 hallucination problem (사실과 다른 내용을 그럴듯해 보이게 생성해내는 문제) 에 관하여 어떻게 해결할 수 있을지에 대한 방법 및 새로운 모델 구조를 제안한다. 좀 더 구체적으로 답을 구하는 문제들은,

- What causes hallucinations?

- Are there other architectures with low generalization error and low hallucinations?

- Are they computationally feasible?

일반적으로 LLM은 다량의 인터넷 데이터를 이용하여 학습된 무수히 많은 parameters로 구성된 모델들이다. 이런 모델들의 hallucination problem의 원인을 분석하기 위해 randomization tests, regularization tests 등의 여러 실험들을 진행했고 거기서 발견된 내용은,

- Pretraining이 완료된 모델이더라도 충분히 큰 사실들을 기억할 수 있는 충분한 capacity를 갖고 있다.

- 중요한 사실들을 기억시키기 위해서는 약 100배 더 많은 SGD step의 모델 학습이 필요하다.

- Generalization error rate이 낮더라도 hallucination 문제가 심각할 수 있다.

이 내용을 기반으로 한다면 충분히 hallucination을 막는 모델을 학습할 수 있으나 결국 계산량이 엄청 많아지는 문제 (비용 문제) 로 귀결된다.

기존에 알려진 hallucinations의 원인들로는,

- 정보의 부재: 학습되지 못한 정보는 모델 자체의 bias로 갭을 매꾸려고 하다보니 inaccurate or fabricated responses 가 생성. 그 대안으로 Retrieval Augmented Generation (RAG) 방식으로 외부 지식을 직접 프롬프트로 주입하는 방식이 고안됨.

- 정보의 충돌: 학습에 이용된 인터넷 규모의 데이터셋 내에 존재하는 상충되는 정보 존재. 이 중 부정확하거나 outdated된 정보를 이용시에 잘못된 정보 출력.

- Sampling noise: decoding시에서의 randomness로 인한 noise 발생. 결국 정보 왜곡으로 발전. ("the noise can lead to the creation of entirely new, yet coherent, sentences that are not grounded in reality")

- Attention glitches: attention mechanism은 입력의 특정 부분에 집중하여 모델이 답변을 생성할 수 있게 하는 역할인데, attention weight이 잘못 계산되어 결국 관련이 적은 정보에 좀 더 집중하는 경우.

이를 해결하기 위해 저자들은 Lamini-1 모델을 제안한다.

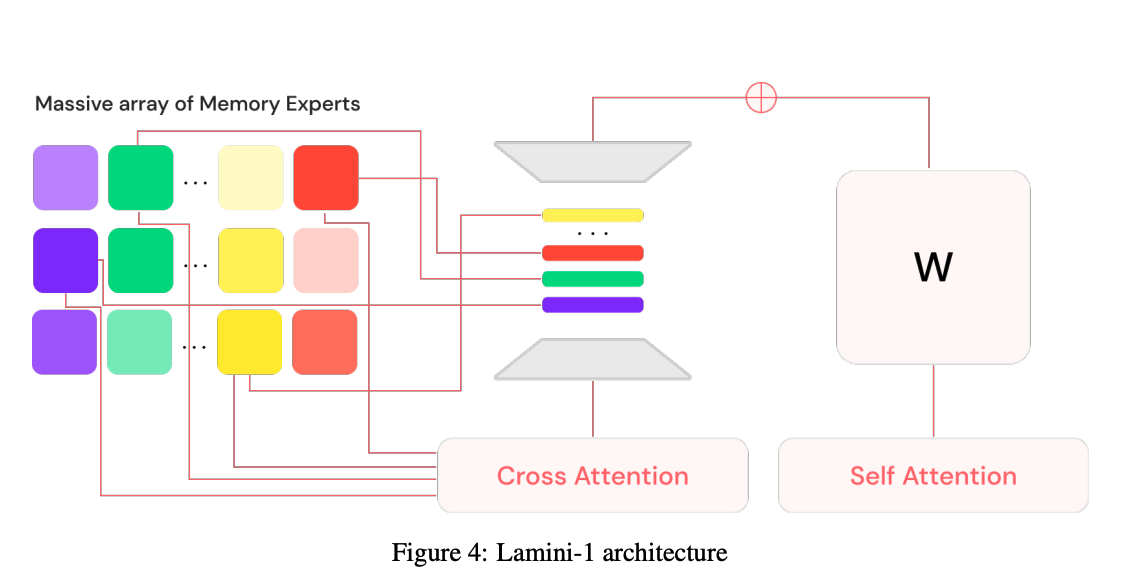

외부에 misture of memory experts (MoME) 메모리 구조를 두고 cross attention을 통하여 필요한 정보를 이용하는 방식이 주요 구조이다. 학습시에는 backbone model은 동결시켜두고 학습하여 특정 사실 정보들만 selected experts에 저장하는 방식으로 동작한다. Inference time에는 단지 relevant experts가 필요 정보를 retrieve하는 방식으로 동작하여 low inference latency를 추구한다. ("cut down on the amount of computation required to memorize facts")

학습 방법:

- 주어진 질문에 subset of experts 선별.

- backbone model params는 동결한 후 cross attention 이용하여 experts들만 연결.

- SGD를 이용하여 experts 에 정보 학습.

여기서 문제는 어떻게 정보들을 experts에 잘 분산하여 저장할지의 방법이 고민.

Insights

- LLMs은 generalization error 증가 없이 쉽게 여러 정보들 기억 가능.

- Generalization error는 hallucination 과 사실 정보를 구분 불가능.

- Hallucination 줄이기 위한 long epochs의 학습은 비효율적. (오히려 scaling law for generalization이 더 효율적)

- training/test set 생성이 많은 노력 필요. 어떻게 샘플링하는지 등등이 많은 영향.

- fine tuned LLM도 여전히 hallucinate.

페이퍼에서 다룬 추가 정보

- Scaling laws and generalization: generalization error 최소화를 위해 많은 데이터를 한번의 epoch로 학습하는 방법이 주로 이용되는데 이로 인해 소량의 정보들은 학습되기 쉽지 않음.

- data cleaning & deduplication은 hallucination 더 악화할 수 있음.

결론

- LLMs can easily memorize random labels without increasing their generalization error, contradicting the notion that hallucinations are a consequence of a balance between creativity and factuality.

- Generalization error does not discriminate between models that hallucinate and those that don't.

- Training long enough to remove hallucinations is computationally intensive and may not be feasible on existing systems.

댓글