Title

Joint Embedding of Words and Labels for Text Classification (2018)

Model

Label Embedding Attentive Model (LEAM)

Links

Summary

이 페이퍼는 래이블의 정보를 함께 이용하여 텍스트 인코딩을 잘 해서 텍스트 분류 작업의 성능을 개선하는 것을 목표로 했다. 가능한 래이블에 대한 임베딩과 단어들의 임베딩 사이에 중요도 (attention score) 를 고려하여 문장을 latent vector로 표현하고 이를 이용하여 텍스트 분류 작업을 하는 방식으로 디자인했다.

최신의 기술들을 적용한 화려한 언어 모델들을 자제하고 최대한 간단한 오퍼레이션을 이용하여 트레이닝/테스팅 시간을 줄이려고 노력했고 attention mechanism을 이용하여 다양한 환경 하의 단어들의 중요도를 배울 수 있고 interpretability도 부가적으로 추구했다.

이전의 래이블 정보를 이용한 문장 인코딩 접근 방식인 Predictive Text Embedding (PTE) 와 다른 점은,

- PTE는 다양한 모델 구조를 이용하고 LEAM은 attentive model을 이용.

- PTE는 단어 임베딩의 단순 평균 값을 이용하고 LEAM은 중요도 (attentive score)에 따라 가중 평균치를 이용.

- PTE는 단어와 래이블 사이의 선형적인 관계를 고려하고, LEAM은 비선형적인 관계도 고려함.

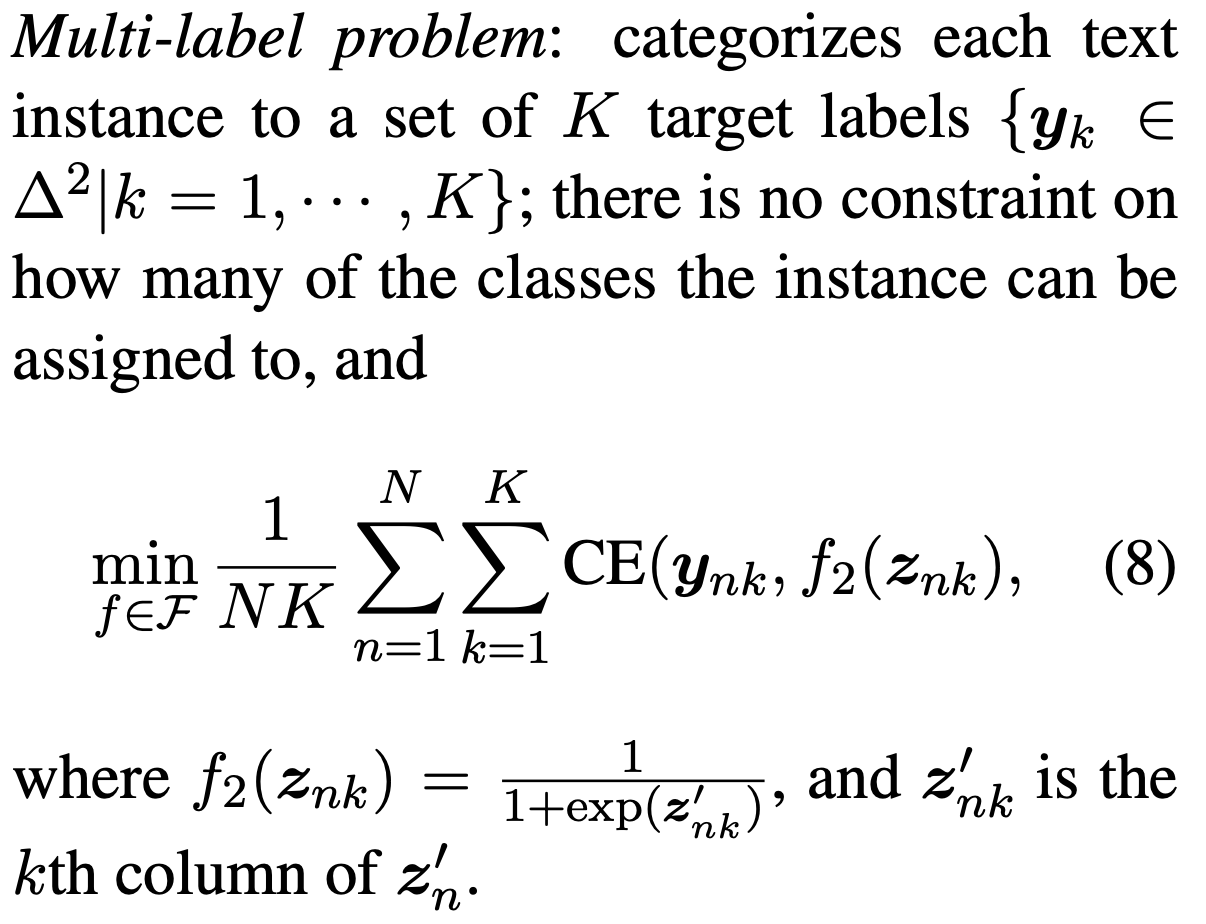

트레이닝 목표 (Training objective)는 기본적인 다중 래이블 분류 작업들과 동일한 cross-entropy loss랑 sigmoid이용한다.

이 모델에서 래이블 정보에서 기대하는 것은 각 클래스의 참조점 (anchor point) 을 제공하여 주어진 문장의 임베딩이 같은 클래스 래이블의 임베딩과 가깝고 다른 클래스 래이블의 임베딩과는 멀게 존재하길 기대한다. 이를 위해서 트레이닝 목표에 아래의 regularization term을 추가한다

Limitations

페이퍼 상에서는 한계점에 대해서 따로 언급은 없었는데 클래스 래이블에 대한 전제조건이 빠져있다. 클래스 래이블이 의미 없는 임의의 이름 (e.g., ClassOne) 이거나 약자 (e.g., AAA) 등등의 실제 단어와 차이가 있는 경우에 래이블과 단어를 같은 임베딩 스페이스에 놓는 데 큰 이득을 기대하기 힘들다. 이런 경우에는 클래스에 연관된 실제 문장 정보 (e.g., 클래스 설명, 클래스 예제 문장, etc)를 이용할 수 있을 것 같다.

또한 클래스 래이블 경우에 다른 최신 기술의 언어 모델을 이용하여 선 트레이닝 시킨 임베딩을 이용할 수 도 있을 것 같다.

댓글